引用:https://arxiv.org/abs/1512.03385

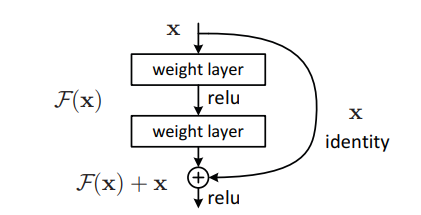

残差接続はニューラルネットワークの入出力を足し合わせる操作のことを指します。

図のようなFで表されるニューラルネットワークを考えます。残差接続の出力Gは以下の式で表されます。G(x)=F(x)+x